KI mit Tools und Teamwork: Was hinter dem MCP-Standard steckt

Lesedauer: 9 Minuten

24. Juli 2025

Durch standardisierte Schnittstellen wie MCP erhält Künstliche Intelligenz Zugriff auf Programme, Datenbanken und Dienste – und wird so vom Sprachmodell zum vielseitigen digitalen Assistenten. In diesem Beitrag zeigen wir, wie spezialisierte KI-Agenten in einem gesteuerten Workflow zusammenarbeiten können und warum Standardisierung der Schlüssel zur nachhaltigen Integration ist.

In unserem letzten Beitrag haben wir die verschiedenen Aspekte des Hostings eines Large Language Models (LLM) beleuchtet und die grundlegende Funktionsweise von Retrieval Augmented Generation (RAG) erklärt – eine Methode, mit der KI-Modelle auf eine konfigurierbare Wissensbasis zugreifen kann, um fundiertere und kontextbezogene Antworten zu liefern. Wenn Sie den Beitrag noch nicht gelesen haben, finden Sie ihn hier:

Prompt zur Vergabe: KI-Einsatz für die öffentliche Beschaffung

In diesem Beitrag betrachten wir die Möglichkeiten, KI unkompliziert Zugang zu Werkzeugen und erweiterten Wissensquellen zu ermöglichen und ein Team von Spezialisten aufzustellen und für Aufgaben einzusetzen.

Schnittstellen als Schlüssel

In unserer bisherigen Betrachtung haben wir KI nur zu Textgenerierung genutzt und dabei verschiedene Wissenspools als Grundlage genutzt. Nun gehen wir einen Schritt weiter und geben dem LLM-Sprachmodell zusätzlich Werkzeuge – in Form von Programmen oder Diensten – in die Hand. Auf diese Weise können wir Anweisungen in natürlicher Sprache formulieren, Dateien zur Bearbeitung hinzufügen oder andere weit komplexere Problemstellungen angehen. Der entscheidende Faktor hier ist die Schnittstelle von unserem KI-System zu den Zielprogrammen oder -diensten.

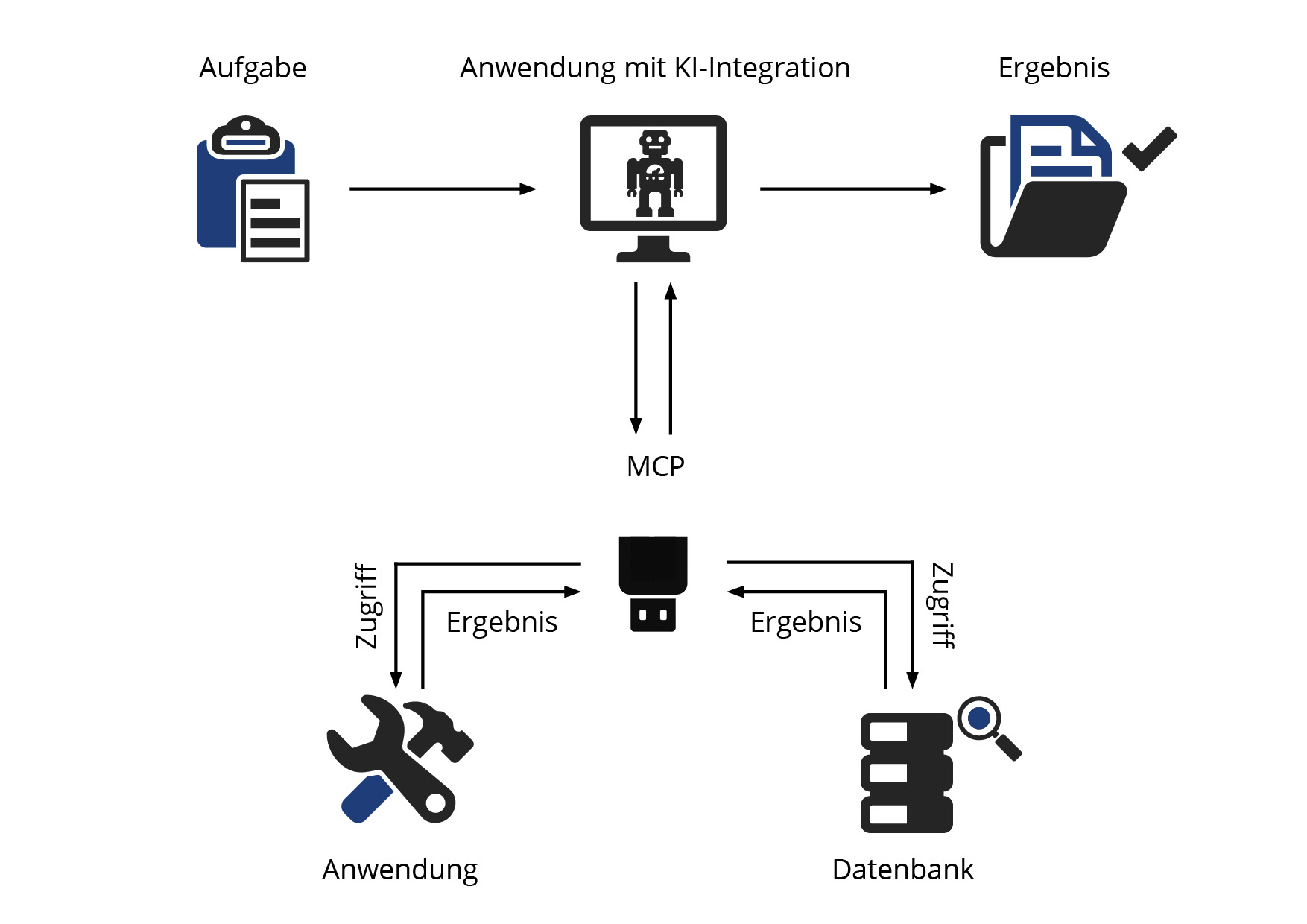

Auf diese Weise wäre es beispielsweise möglich, die Bildbearbeitung von der KI in Photoshop durchführen zu lassen. Man formuliert die Anforderungen an die Bearbeitung, verweist auf das entsprechende Bild und gewährt Zugang zum Programm. Über die Schnittstelle kann die KI nun mit dem Programm interagieren und die Anweisungen selbstständig umsetzen. Technisch möglich wird dieses Zusammenspiel durch eine zentrale Schnittstelle wie MCP. Sie sorgt dafür, dass die KI gezielt mit externen Tools kommunizieren kann – klar begrenzt, nachvollziehbar und kontrollierbar.

MCP - Der Universalanschluss für KI

Model Context Protocol (MCP) ist ein offener Protokollstandard ursprünglich entwickelt von der Firma Anthropic, Anbieter des Chatbots „Claude“. MCP soll eine standardisierte Kommunikation zwischen LLMs und anderen Systemen/Diensten bilden. Dies kann Programme umfassen, aber auch Datenbanken oder im Web verfügbare Dienste. Theoretisch sind hier keine Grenzen gesetzt, solange diese Standardverbindung von Seiten des Anbieters möglich gemacht wird.

Bisher gibt es viele proprietäre Verbindungen von Diensten zu KI-Anwendung, was dazu führt, dass für jede Verbindung eine eigene Schnittstelle gebaut werden muss. Dies ist vergleichbar mit der Flut an verschiedenen Handyladekabeln, die es vor dem einheitlichen USB-Standard gab. Mittlerweile ist USB-C der Standard für Ladekabel aller elektronischen Kleingeräte.

MCP möchte nun der USB-Stecker für KI-Systeme werden. Da der Standard Open Source ist, kann jeder Anbieter diesen kostenlos umsetzen und die Liste der Dienste, welche die Schnittstelle umgesetzt haben, wächst schnell. Auch Googles KI-Abteilung Deepmind sowie OpenAI haben angekündigt, den Standard umzusetzen.

Sobald Verbindungen zu all den Systemen oder Datenbanken bestehen, kann das LLM damit arbeiten. Auf diese Weise lässt sich beispielsweise einfach die Datenbasis des Modells erweitern und so Ergebnisse verbessern. Wie auch in unserem letzten Beitrag haben Anwender die Wahl, ob sie diese Werkzeuge oder Dienste lokal hosten möchten oder auf öffentliche Dienste zugreifen möchten. Aber was, wenn wir nicht nur eine KI mit der Arbeit beauftragen, sondern ein spezialisiertes Team, das sich die Aufgaben aufteilt?

KI-Agenten im Einsatz

Wir stellen uns eine Vergabestelle vor, die eine umfangreiche Ausschreibung für eine neue IT-Infrastruktur auf den Weg bringen will. Viele Beteiligte müssen nun unterschiedliche Aufgaben erledigen, damit die Ausschreibung rechtssicher, vollständig und termingerecht veröffentlicht werden kann. Es muss eine passende Leistungsbeschreibung auf Basis der Anforderungen erstellt werden, es sind geeignete Eignungs- und Zuschlagskriterien zu definieren, die Vergabeunterlagen müssen formal korrekt zusammengestellt werden und am Ende müssen die eingehenden Angebote ausgewertet und verglichen werden. Eine Vielzahl spezialisierter Tätigkeiten, die ineinandergreifen und aufeinander aufbauen. Diese Zusammenarbeit lässt sich durch KI-Agenten abbilden und effizient unterstützen.

KI-Agenten sind Programme, die auf ein bestehendes Sprachmodell (LLM) aufbauen und dessen Fähigkeiten nutzen, um spezialisierte Aufgaben zu übernehmen und ein gemeinsames Ergebnis zu erzielen. Ihre Rollen sind dabei frei definierbar und können flexibel an den jeweiligen Arbeitsprozess angepasst werden. In unserem Beispiel der Vergabestelle könnten folgende KI-Agenten zum Einsatz kommen:

- Ausschreibungsassistent: Analysiert den Bedarf und erstellt auf Basis früherer Verfahren sowie eigener Recherchen und rechtlicher Rahmenbedingungen Vorschläge für die Leistungsbeschreibung, Losbildung und Kriterien.

- Vergabeunterlagen-Koordinator: Setzt aus den vorhandenen Inhalten, Vorlagen und Vorgaben automatisiert ein vollständiges Unterlagenpaket zusammen und bereitet es für die Freigabe vor.

- Vergabeanalyse-Scout: Sichtet die eingegangenen Angebote, prüft auf formale Vollständigkeit und bereitet die Daten für einen strukturierten Angebotsvergleich visuell und tabellarisch auf.

Als Ergebnis erhalten wir eine deutlich effizientere, konsistentere und besser vorbereitete Ausschreibung – rechtssicher und vollständig, aber immer unter menschlicher Aufsicht und Entscheidungshoheit.

Assistenz statt Autopilot: KI im gesteuerten Workflow

Nun wird das Potenzial deutlich, sobald KI mehr als nur Sprachverarbeitung übernimmt. Im Beispiel der Vergabestelle sehen wir Rollen, die mit internen Dokumenten (Vergabeunterlagen, Verfahrensvorlagen), strukturierten Daten (Angebote) und externen Wissensquellen (Rechtsvorgaben, Marktinformationen) arbeiten müssen. Über MCP wird diese Verbindung möglich gemacht.

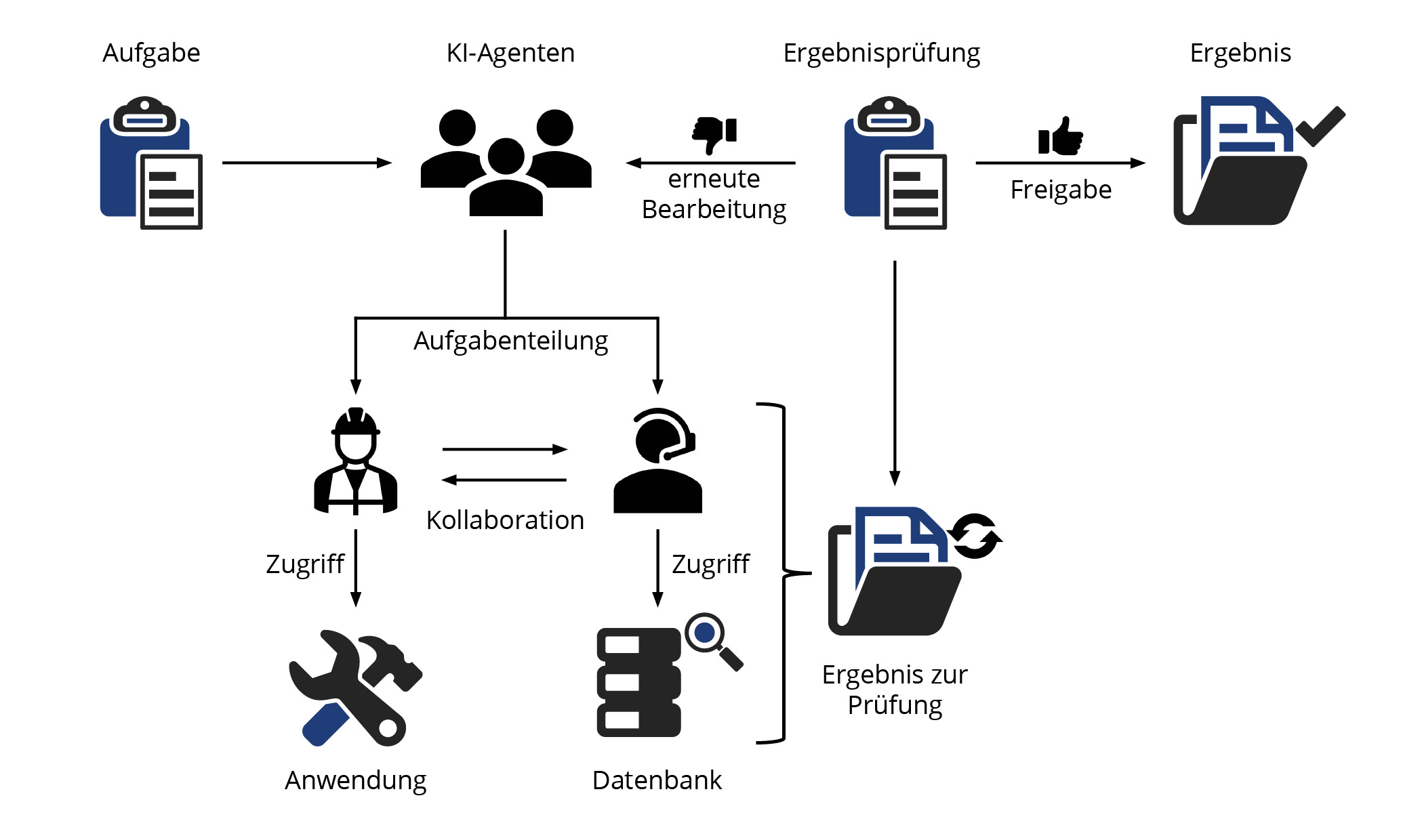

Wie genau die einzelnen Agenten zusammenarbeiten, wie Informationen zwischen ihnen fließen und wann menschliches Eingreifen erforderlich ist, wird durch einen frei definierbaren Workflow gesteuert. So analysiert zunächst der Ausschreibungsassistent den Bedarf und generiert erste Textvorschläge. Diese werden anschließend vom Vergabeunterlagen-Koordinator in ein vollständiges Dokumentenpaket überführt, das wiederum durch den Menschen freigegeben werden muss. Nach Eingang der Angebote übernimmt der Vergabeanalyse-Scout die erste Sichtung und erstellt automatisch Vergleichsübersichten – immer im Rahmen der im Workflow festgelegten Regeln und Prüfungen.

Der Mensch bleibt dabei stets im Zentrum: Er gibt Feedback, nimmt Korrekturen vor und trifft die finalen Entscheidungen. Die KI arbeitet assistierend, nicht autonom – ein klar gesteuerter Prozess, der Transparenz und Kontrolle sicherstellt.

In dem hier illustrierten Beispielworkflow gibt der Nutzer eine Aufgabe an die KI-Agenten. Die Aufgabenstellung wird evaluiert und in Teilaufgaben mit entsprechenden Ergebnissen gegliedert. Diese werden anschließend an die einzelnen Agenten verteilt. Diese Arbeiten per MCP-Zugriff mit ihren Programmen oder Diensten an der Bewältigung der Aufgabe und tauschen sich für die Zusammenstellung des Ergebnisses aus. Ein vorläufiges Ergebnis wird dann zur Prüfung vorgelegt. Nun bewertet eine Instanz das Ergebnis in Relation zur ursprünglichen Aufgabe und entscheidet, ob diese erfüllt wurde. Trifft dies nicht zu, wird die Aufgabe erneut an die Agenten mit Anpassungen zur Überarbeitung gegeben. Ist die Aufgabe erfüllt, wird das Ergebnis dem Nutzer zur eigenen Prüfung vorgelegt.

Der Nutzer behält somit die volle Kontrolle über die Arbeitsweise seiner KI-Agenten. Er selbst legt fest, an welchen Punkten Zwischenergebnisse durch das LLM evaluiert werden müssen, oder auch zur Kontrolle vorgelegt werden sollen. Der Nutzer kann somit beispielsweise selbst in die Rolle des Vergabeverantwortlichen treten und Ergebnisse zu jedem Zeitpunkt kontrollieren, bevor fortgefahren wird. Er kann diese Arbeit jedoch auch abgeben und nur das finale Ergebnis prüfen.

Weiterhin gibt es auch Aufgaben, die nicht von KI übernommen werden können – oder sollen. Im Kontext der Vergabestelle sind dies etwa juristisch oder politisch sensible Entscheidungen, Abstimmungen mit Bedarfsträgern oder individuelle Ermessensentscheidungen bei der Bewertung von Angeboten. Hier bleiben das Fachwissen und die Verantwortung klar beim Menschen.

So könnte etwa ein Projektverantwortlicher individuelle Anforderungen zu einer Beschaffung definieren oder bestimmte Wertungsaspekte festlegen, die dann in den KI-gestützten Workflow eingespeist werden. Auch die finale Vergabeentscheidung bleibt stets in menschlicher Hand. Die Mitarbeitenden werden so zu aktiven Gestaltern im digitalen Prozess – als Qualitäts- und Verantwortungssicherung.

Die Art und Weise dieser Zusammenarbeit ist letztlich nur eine Frage der Konfiguration: Vom punktuellen Einsatz einzelner Agenten in definierten Arbeitsschritten bis hin zur nahezu vollautomatisierten Vorbereitung des Verfahrens bis zur Veröffentlichung und anschließenden Aufbereitung bis zum Zuschlag ist alles möglich.

Standardisierung mit Weitblick

Als Administration Intelligence AG unterstützen wir die Entwicklung einer einheitlichen Schnittstelle mit Überzeugung – nicht nur, weil Standardisierung die Integration erleichtert, sondern weil wir für offene und zukunftsfähige Systemlandschaften stehen. Deshalb verfolgen wir aktiv die Umsetzung des MCP-Standards in unsere eigenen Systeme, um unseren Kunden die größtmögliche Freiheit bei der Integration von KI in ihrem AI BESCHAFFUNGSPORTAL zu ermöglichen. Wenn Sie Fragen oder auch Anregungen zu den Themen KI, MCP oder KI-Agenten haben oder konkrete Vorstellungen einer Integration haben, kommen Sie auf uns zu. Wir analysieren in gemeinsamen Workshops Ihre Vorstellungen sowie die Ausgangslage und erarbeiten die beste Umsetzung mit Ihnen.

Bei weiteren Fragen können Sie gerne Kontakt mit uns aufnehmen (vertrieb@ai-ag.de).

Autor: Steffen Donath

Technischer Redakteur