Prompt zur Vergabe – KI-Einsatz für die öffentliche Beschaffung

Lesedauer: 4 Minuten

07. Juli 2025

Zwischen Innovationstreiber und Datenschutzrisiko: Der Einsatz von KI wirft viele Fragen auf. Sollten Sie auf frei verfügbare Modelle setzen oder lieber eigene Systeme hosten? In unserem Beitrag zeigen wir, wie Sie KI sicher, rechtskonform und zielführend in Vergabeprozessen einsetzen – und welche Lösungen sich für Ihren konkreten Anwendungsfall am besten eignen.

In diesem Beitrag zeigen wir auf, wie LLMs konkret bereitgestellt werden können. Wir erläutern die Vor- und Nachteile der beiden Varianten. So erhalten Sie die nötigen Informationen, um zu entscheiden, ob und in welcher Form Sie KI am besten einsetzen können.

Die Hosting-Frage

Eine grundlegende Frage beim Einsatz von KI ist die Entscheidung, ob man eine eigene, lokal gehostete Lösung betreiben oder auf öffentlich zugängliche KI-Dienste zurückgreifen möchte. Frei verfügbare Modelle wie Open AIs ChatGPT, Googles Gemini usw. sind sehr einfach im Einsatz. Sie sind browserbasiert und benötigen in manchen Fällen noch nicht einmal einen Account. Viele Anbieter bieten darüber hinaus Abo-Modelle an, die Zugang zu besseren Modellen des Anbieters oder weiteren Funktionen wie Videogenerierung ermöglicht.

Die berechtigte Sorge ist in diesem Fall allen voran der Datenschutz. Wird beispielsweise ChatGPT zum Erstellen einer Leistungsbeschreibung eingesetzt, so erhält die Firma dahinter nicht nur alle Eingaben des Nutzers in Form von Prompts und allen Dateien, die zusätzlich hochgeladen werden, auch Meta-Informationen werden

gesammelt. Hier können, je nach Anbieter, Standortdaten, Browserdaten, App-Informationen, Telefonnummer etc. gesammelt und verarbeitet werden. Diese Daten fließen in das fortlaufende Training des Modells ein und sind somit auf eine gewisse Art und Weise öffentlich. In manchen Fällen werden diese Daten auch an Dritte weitergegeben. Oft mangelt es an Transparenz vonseiten der Anbieter, welche Daten genau erfasst und verarbeitet werden. Die sichere Alternative mit voller Kontrolle ist das Self-Hosting.

„LLM-Betreiber sammeln umfangreich persönliche Daten und geben diese weiter“ (heise.de)“

KI vor Ort

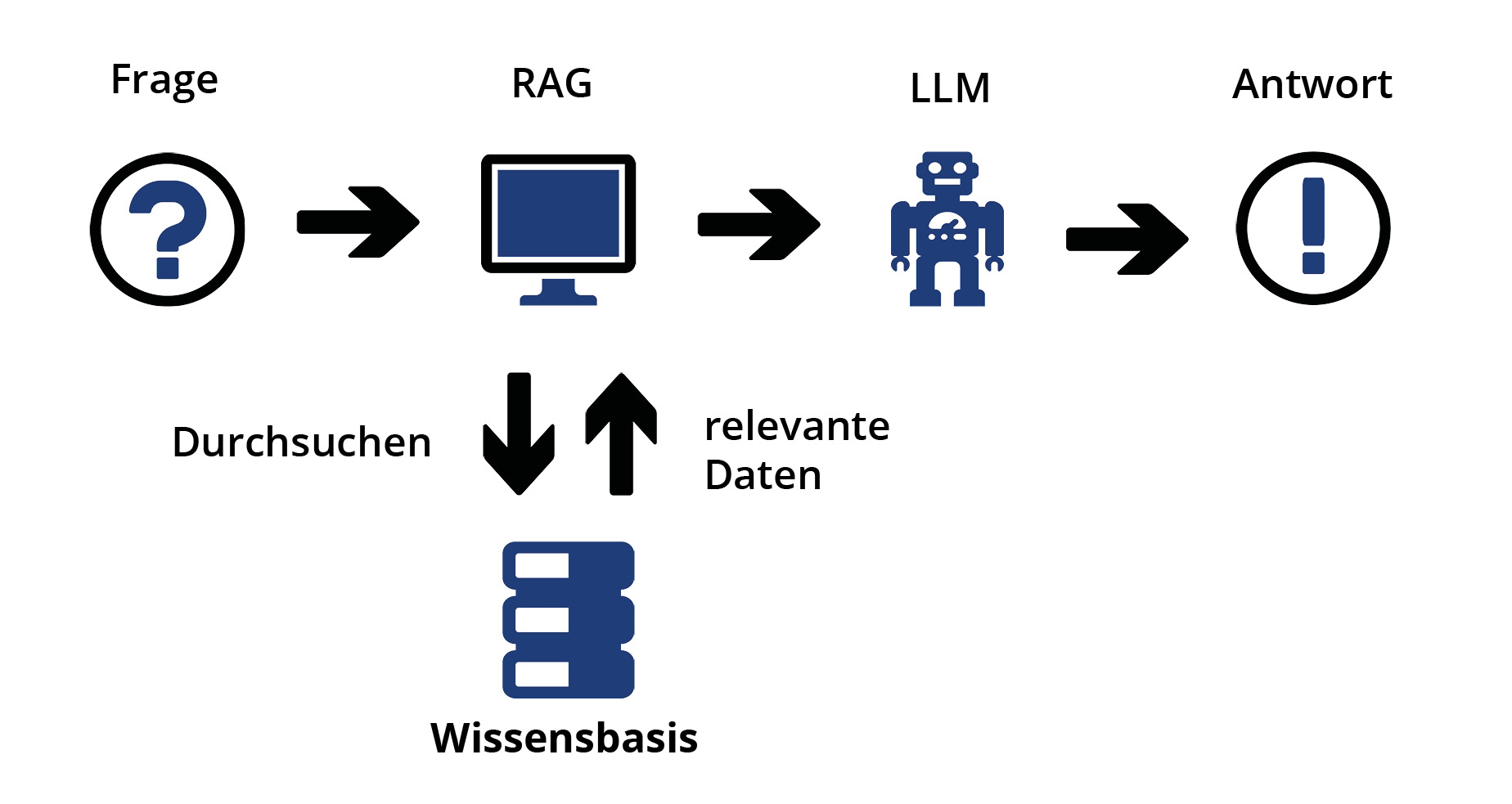

Ein Nachteil dieser Variante ist, dass die Performanz – sowohl im Hinblick auf Antwortzeit und Qualität der Antworten – direkt von der eingesetzten Hardware abhängig ist. Leistungsfähigere Hardware ist hier direkt proportional zu mehr Geschwindigkeit und höherer Qualität. Aber das eigene Betreiben eines derartigen Systems bietet noch weitere Potenziale, wie das Nutzen der eigenen Daten als Wissensbasis.

Die eigenen Daten befragen

generiert wurde. Dies ist ein weiterer Unterschied zu öffentlichen Modellen, bei denen die Quellen undurchsichtig bleiben.

Ein weiterer Pluspunkt dieser Variante ist die Flexibilität der Wissensbasis. Wenn sich Best-Practices ändern oder neue Regelungen festgelegt wurden, kann die Wissensbasis des RAG-LLM einfach um die neuen Daten erweitert werden bzw. obsolete Daten können entfernt werden. Das Modell kann so mit niedrigem Zeit- und Kostenaufwand aktuell gehalten werden bei voller Kontrolle über den Datensatz und ohne die Gefahr von Urheberrechtsverletzungen.

KI in der Praxis

Ein praxisnahes Szenario: Eine Vergabestelle prüft ihre Unterlagen vor der Veröffentlichung mithilfe eines frei verfügbaren KI-Modells auf mögliche Schwachstellen – etwa im Hinblick auf ein Nachprüfverfahren. Denn auch Bieter können solche Werkzeuge nutzen, um potenzielle Fehler oder Unklarheiten aufzudecken. Vergabestellen können auf diese Weise mögliche Risiken vorwegnehmen und mit den Werkzeugen der Bieter schritthalten.

Die selbst-gehostete Variante hingegen ist besonders attraktiv, wenn es darum geht, die eigenen Daten bestmöglich nutzbar zu machen. Neben der bereits erwähnten Kontrolle über die Sicherheit der eigenen Daten haben Nutzer dieser Variante auch die Qualität komplett in der Hand. Des Weiteren ist man mit dieser Variante deutlich agiler. Wird beispielsweise ein neuer Leitfaden zur nachhaltigen Beschaffung von Druckern herausgegeben, so kann dieser am gleichen Tag in das RAG LLM importiert und direkt genutzt werden. Gleichzeitig bedeutet dies aber auch, dass das Modell selbst gepflegt werden muss. Ohne Verbindung zum Internet, wie bei öffentlichen Modellen, liegt es in der eigenen Verantwortung, den Datensatz aktuell zu halten.

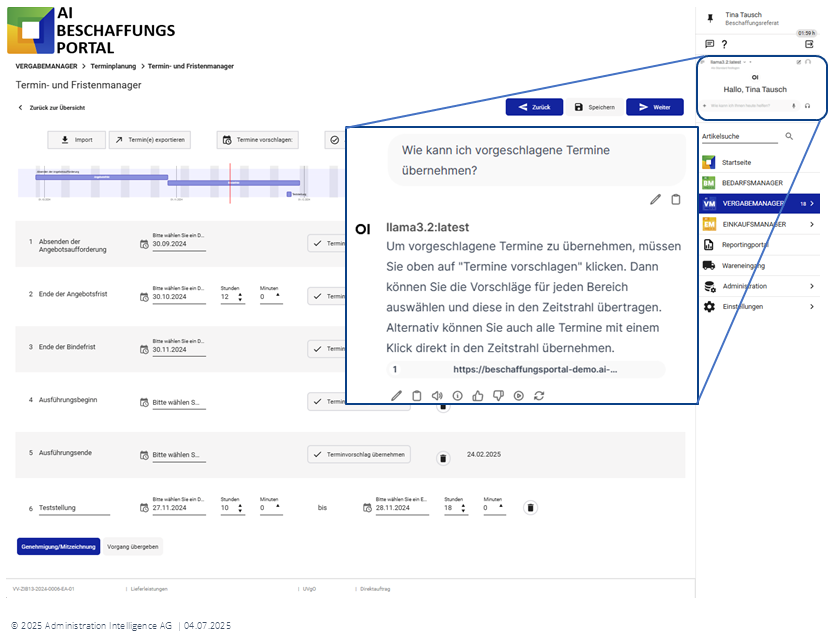

Integration im AI BESCHAFFUNGSPORTAL

Unseren Kunden stehen alle Möglichkeiten zur Nutzung von KI offen. Beide aufgezeigten Varianten können einfach in unser AI BESCHAFFUNGSPORTAL integriert werden. Hierbei muss auch keine globale Entscheidung getroffen werden. Bekanntmachungen können beispielsweise von einem öffentlichen Modell geprüft werden, während Leistungsbeschreibungen mit einem eigenen Modell erstellt werden.

Ein weiterer möglicher Einsatz für diese Form von KI-Assistenz sind kurze Fragen zur Software selbst. Anstatt das Benutzerhandbuch aufzurufen, kann dieses direkt mit der konkreten Problemstellung befragt werden. Auch hier würde das Modell die genaue Quelle angeben, sodass ein Nachlesen der Details möglich ist, falls die kurze Antwort nicht ausreicht.

AI AG – Ihr Experte für KI in der öffentlichen Beschaffung

Wir beraten Sie gerne in all Ihren Fragen rund um KI und deren Einsatz. Wir analysieren Ihre Bedürfnisse und Datenschutzanforderungen und erstellen darauf mit Ihnen zusammen die passende Variante der KI-Integration in Ihr AI BESCHAFFUNGSPORTAL. Auch beim Thema Hosting eines eigenen Modells unterstützen wir Sie gerne bei der Bereitstellung.

In unserem nächsten Beitrag zum Thema KI werden wir uns einer besonderen Einsatzform und deren Potenzial zuwenden: Der Einsatz von KI-Agenten.

Bei weiteren Fragen können Sie gerne Kontakt mit uns aufnehmen (vertrieb@ai-ag.de).

Autor: Steffen Donath

Technischer Redakteur